Digitale Bibliothek: Simulation von Nutzerinteraktionen zur Optimierung der Literaturrecherche

Will man das Nutzungserlebnis bei der Literaturrecherche optimieren, waren bislang langwierige und teure Tests mit echten Nutzenden erforderlich. Das Projekt SINIR hat sich zum Ziel gesetzt, Test- und Entwicklungsaufwände für Anpassungen bibliothekarischer Suchsysteme deutlich zu reduzieren, indem es auf Simulationen von Nutzerinteraktionen setzt. So sollen Änderungen in solchen Suchsystemen bereits im Vorfeld ihrer produktiven Einführung hinsichtlich ihrer tatsächlichen Auswirkungen antizipiert und evaluiert werden.

im Interview mit Timo Borst

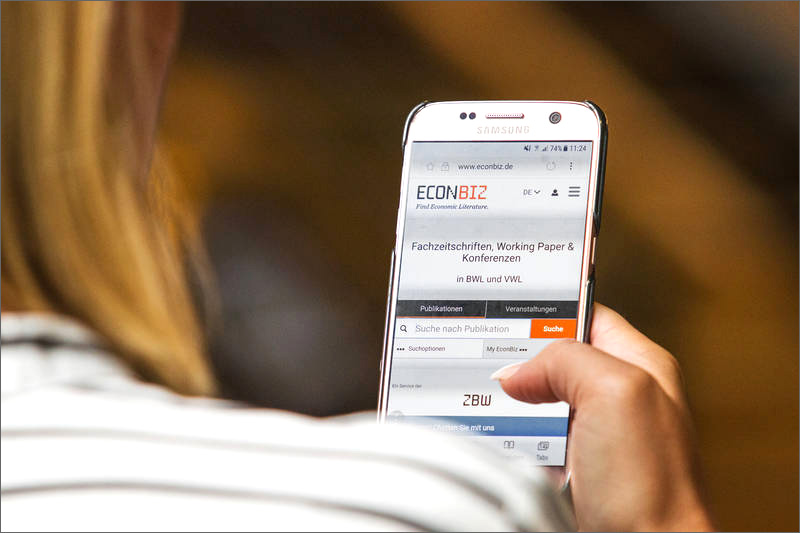

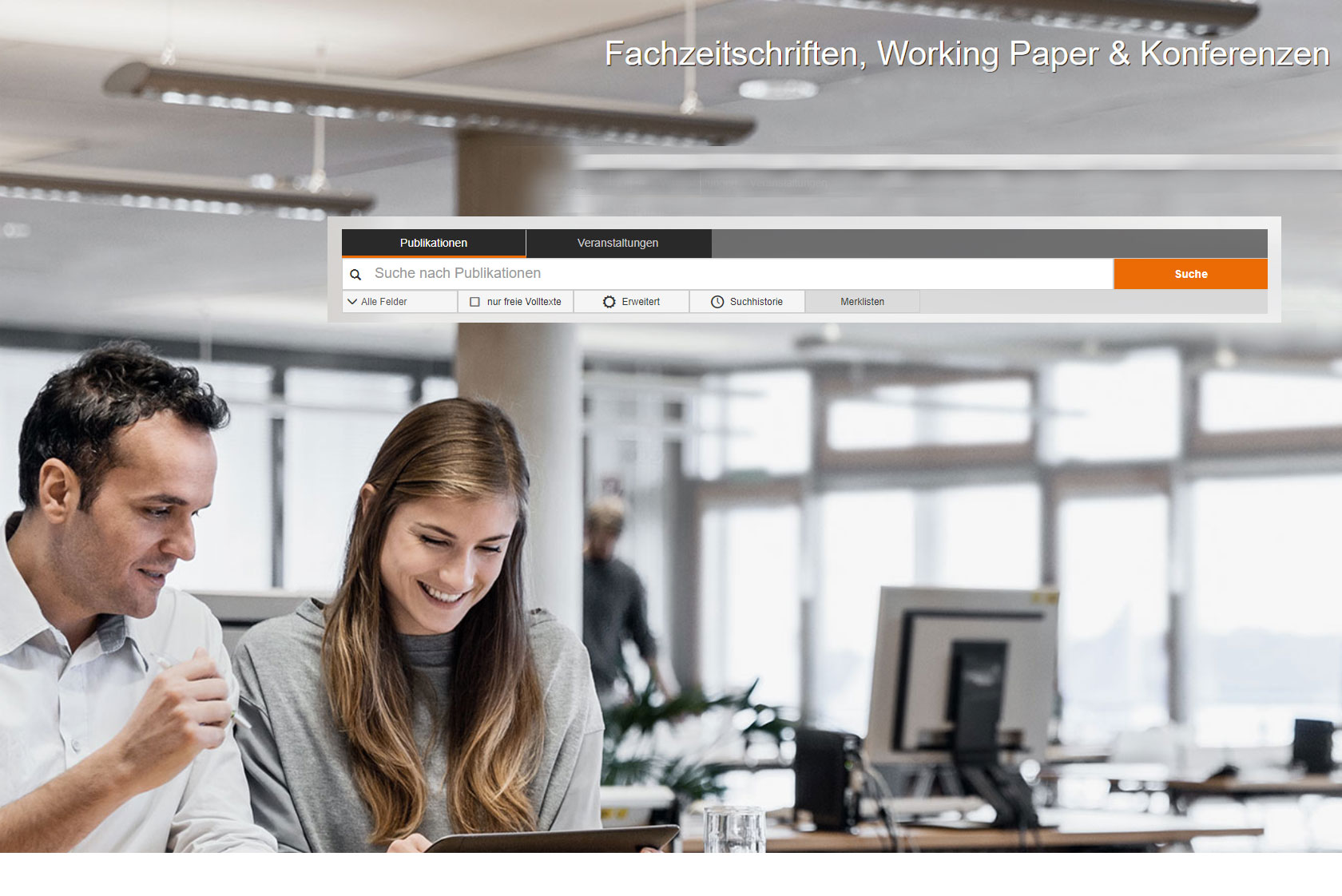

Das DFG-Projekt SINIR („Simulating Interactive Information Retrieval“) startete am 01. Oktober 2019. Es ist ein Kooperationsprojekt der ZBW – Leibniz-Informationszentrum Wirtschaft mit den Universitäten Weimar und Passau sowie mit Christin Seifert von der Universität Twente als assoziierter Partnerin. In dem Projekt werden in den kommenden drei Jahren Verfahren zur Simulation von Nutzerinteraktionen im Kontext des wirtschaftswissenschaftlichen Fachportals EconBiz erforscht und entwickelt. Wir sprachen mit Dr. Timo Borst, Leiter der Abteilung Informationssysteme und Publikationstechnologien bei der ZBW – Leibniz-Informationszentrum Wirtschaft, über das Projekt.

Das DFG-Projekt SINIR („Simulating Interactive Information Retrieval“) startete am 01. Oktober 2019. Es ist ein Kooperationsprojekt der ZBW – Leibniz-Informationszentrum Wirtschaft mit den Universitäten Weimar und Passau sowie mit Christin Seifert von der Universität Twente als assoziierter Partnerin. In dem Projekt werden in den kommenden drei Jahren Verfahren zur Simulation von Nutzerinteraktionen im Kontext des wirtschaftswissenschaftlichen Fachportals EconBiz erforscht und entwickelt. Wir sprachen mit Dr. Timo Borst, Leiter der Abteilung Informationssysteme und Publikationstechnologien bei der ZBW – Leibniz-Informationszentrum Wirtschaft, über das Projekt.

Was ist das Ziel bei SINIR?

Durch den alltäglichen Umgang mit Google und ähnlichen Suchmaschinen erwarten Nutzende wie selbstverständlich, dass die angezeigten Treffer zu den relevantesten gehören, die ihrer Suchanfrage entsprechen. Diese Erwartungshaltung übertragen sie im Grunde auch auf ein fachliches Suchportal wie EconBiz, wobei sie hier im Anschluss an eine Suche noch weitergehende Aktionen ausführen oder anstoßen können: Sie können die Ergebnisse beziehungsweise ihre Suche über query reformulation verfeinern, sie können einzelne Treffer aufrufen, die dahinterliegende Publikation herunterladen, oder sich anderweitig Zugriff auf die (geschützten) Dokumente verschaffen. Vor dem Hintergrund dieser Nutzungsszenarien verfolgen wir mit SINIR hauptsächlich die folgenden beiden Ziele:

Zum einen geht es uns darum, überhaupt erst einmal eine belastbare Datenbasis zu den oben genannten Aktivitäten zu gewinnen. Bei der Gestaltung von Nutzerinteraktionen, die über ein Webinterface wie das von EconBiz gesteuert werden, verlassen wir uns bisher weitgehend auf branchenübliche Standards und Konventionen, ferner auf die von Suchportaltechnologien wie dem Community-Projekt VuFind zum Beispiel über Templates mitgelieferten Funktionalitäten. Empirisch gesehen, das heißt auf Basis einer systematischen Erhebung und Auswertung von Nutzungsdaten, wissen wir aber dabei gar nicht genau, ob die Nutzerinteraktionen, wie wir sie lediglich annehmen, in der gedachten Weise auch tatsächlich stattfinden und die Nutzererwartungen erfüllen.

So könnte es beispielsweise sein, dass unsere Nutzerinnen und Nutzer so etwas wie die Vorschau eines Dokuments – etwa durch Einblenden zumindest der ersten Seite eines Artikels oder des Inhaltsverzeichnisses eines Werks –nützlich fänden. Uns fehlt aber bis dato ein Rahmen, um solche Hypothesen hinsichtlich eines optimierten Interface-Designs eindeutig, das heißt empirisch nachvollziehbar, überhaupt formulieren, dann aber natürlich auch prüfen zu können.

Neben diesem methodischen Aspekt verfolgt SINIR aber auch eine inhaltliche Zielstellung: Es geht darum, bestehende oder geplante Nutzerinteraktionen so zu modellieren und zu simulieren, dass damit bessere Prognosen hinsichtlich des zu erwartenden Nutzereffekts als quasi-betriebswirtschaftliche Kosten-Nutzen-Rechnung (cost/gain effect) getroffen werden können. Um am obigen Beispiel zu bleiben: Wir wollen mit SINIR die Vorschau-Funktionalität in eine simulationsförmige Umgebung einführen und erproben können, bevor wir eine solche Funktionalität dann tatsächlich in das Produktivsystem einführen. Denn letzteres bedingt häufig einen recht tiefgreifenden Eingriff, der zum einen Nutzende irritieren oder überfordern könnte, und der andererseits nicht zu den gewünschten oder geplanten positiven Effekten führt. Gerade im letztgenannten Fall ist es aber häufig schwierig, einmal getroffene Änderungen ohne weiteres wieder rückgängig zu machen. Daher soll SINIR dabei helfen, Irrwege beim Interaktionsdesign möglichst frühzeitig zu entdecken und – im positiven Fall –Innovationszyklen bei der Entwicklung einer digitalen Bibliothek wie EconBiz grundsätzlich zu verkürzen.

Welche konkreten Verbesserungen werden mit SINIR angestrebt?

Wie bereits angesprochen, soll SINIR zunächst grundlegend dabei helfen, Innovationszyklen bei der Entwicklung einer digitalen Bibliothek und Suchanwendung wie EconBiz zu verkürzen. Denn solche Innovationen stehen unter Bedingungen, die sie erschweren, wenn nicht von vornherein unmöglich machen. So beruhen solche Innovationen auf Eingriffen in die Nutzerführung, die bisher – und vornehmlich bei großen Suchmaschinen – nur mit aufwändigen A/B-Tests evaluiert werden können. Digitale Bibliotheken mit einer prinzipiell kleineren, relativ homogenen Nutzerschaft können solche A/B-Tests in ihrem jeweiligen Umfeld jedoch nur bedingt durchführen. Daher erhoffen wir uns, mit SINIR einen konkreten Weg aufzuzeigen, wie A/B-Tests durch simulierte Nutzerinteraktionen zumindest insoweit unterstützt werden können, dass von vornherein nur noch die aussichtsreichsten „Systemkandidaten“ für echte Nutzungstests und Feldexperimente in Betracht gezogen werden.

Wie geht ihr vor?

Zunächst gilt es, eine sogenannte ‘Baseline’ zu definieren, das heißt einen Zustand des Informationssystems einschließlich seiner Daten und – nach Relevanz sortierten beziehungsweise bewerteten – Trefferlisten, der als Ausgangspunkt für Simulationen und Evaluierungen dienen kann. Für die konkreten Nutzungsanalysen machen wir Gebrauch sowohl von den Query-Logs, die die Suchanfrage beziehungsweise deren Reformulierung beinhalten als auch von den eventbezogenen Interaction-Logs, die die Interaktion des Nutzers mit dem Retrieval-System dokumentieren. Typische solcher Events beziehen sich auf eine Trefferliste und bestehen in Nutzeraktionen wie der Auswahl einer Facette, der Auswahl eines Einzeltreffers, oder dem Download eines Dokuments. Aus diesen Interaktionen abstrahieren wir Nutzermodelle, die quasi als Ausgangspunkt für Simulationen und daraus gegebenenfalls ableitbaren Optimierungen dienen können. Eine wesentliche Frage dabei ist der Zusammenhang zwischen der ursprünglichen Suchanfrage, dem Suchergebnis in Form einer sortierten Trefferliste sowie den sich hier anschließenden Nutzerinteraktionen: Da sich die Sequenz dieser Interaktionen hinsichtlich ihrer Länge und Varianz in Abhängigkeit von der Sortierreihenfolge erheblich unterscheiden kann, ist das dieser Reihenfolge zugrundeliegende Relevanzmodell von mitunter erheblicher Bedeutung für die Bewertung und Optimierung eines Information-Retrieval-Systems (IR-Systems).

Mit unseren Simulationen versuchen wir konkretes Interaktionsverhalten zu prognostizieren, nicht dieses zu ersetzen. In diesem Sinne stellen wir Testnutzerinnen und -nutzern Aufgaben in Form von artikulierten Informationsbedürfnissen, die die Nutzerinnen und Nutzer durch ihre Interaktionen mit dem zuvor simulierten IR-System möglichst befriedigen sollen. Beispielsweise lautet ein solches Informationsbedürfnis „Welche Effekte hat der Brexit auf die europäische Wirtschaftszone?“. Auch in Abhängigkeit davon, wie diese Anfrage dem System mitgeteilt wird, erhält der Testnutzer eine nach Relevanz sortierte Trefferliste als Ausgangspunkt für seine weiteren Interaktionen – bis hin zum Aufruf oder Download eines Dokuments, also dem mutmaßlichen Ergebnis und Ende seiner Interaktion. Da sich die Informationsbedürfnisse als Ausgangspunkt der Analyse und Bewertung eines jeden IR-Systems nicht direkt in den Nutzungsdaten wiederfinden, rekonstruieren beziehungsweise formulieren wir sie auf dreierlei Weise: Erstens als Kollektion heruntergeladener Dokumente, die dem Informationsbedürfnis entsprechen, zweitens als prosaische Beschreibung oder Aufgabe, oder drittens als initiale Suchanfrage, die dann noch weiter zu verfeinern wäre.

Wie simuliert ihr Nutzerinteraktionen?

Zum einen erzeugen wir die schon angesprochenen Nutzermodelle, um ein konkretes Interaktionsverhalten simulieren zu können. Zu solchen Nutzermodellen gehören die in einem IR-System typischen, durch sein Interface und seine Funktionalität vorgegebenen, Interaktionen beziehungsweise Sequenzen, wie eine Suchanfrage stellen, ein Suchergebnis in Form einer Liste erhalten oder einen Treffer hieraus auswählen. Wir verstehen den simulierten Suchprozess nun als eine mehr oder weniger geordnete Abfolge dieser Interaktionen, wobei diese Abfolge nicht statisch bleibt, sondern sich angesichts bereits gefundener Informationen ändern kann – so könnte sich beispielsweise die Wahrscheinlichkeit verringern, dass ein Treffer nochmals aus einer Liste ausgewählt wird, wenn dies zuvor bereits der Fall war und andere Treffer in der Zwischenzeit aktiviert wurden.

Welche besonderen Herausforderungen birgt SINIR? Wie wollt ihr sie angehen?

Wie immer bei der Simulation menschlichen Verhaltens stellt sich natürlich auch für uns im Rahmen des Projekts die Frage, ob und inwieweit die simulierten Interaktionen den tatsächlichen entsprechen können in dem Sinne, dass sie letztere vorhersagen oder gar ersetzen können. Im Prinzip bieten solche Simulationen verschiedene Mehrwerte, wie etwa relativ aufwendige A/B-Tests zumindest ergänzen oder im Vorfeld filtern zu können, oder tatsächliche Nutzungsdaten nicht länger als notwendig sammeln oder vorhalten zu müssen, beziehungsweise in anderen Umgebungen darauf gänzlich verzichten zu können. Hier müssen wir im Laufe des Projekts einfach sehen, ob und wie wir Nutzerinteraktionen so simulieren können, dass sie auch zu empirisch triftigen Vorhersagemodellen führen.

Dr. Timo Borst ist Leiter der Abteilung Innovative Informationssysteme und Publikationstechnologien bei der ZBW – Leibniz-Informationszentrum Wirtschaft. Er beschäftigt sich mit offenen bibliografischen Daten und Systemen, die ihrer Erzeugung, Verarbeitung, Normierung und Verknüpfung dienen. Dazu zählen sowohl die hauseigenen ZBW-Anwendungen als auch externe Datenhubs wie Wikidata. Er ist auch auf LinkedIn, ORCID, ResearchGate und Twitter zu finden.

Porträt: ZBW©

View Comments

Forscherprofile in EconBiz: Halbautomatische Generierung mit Linked Open Data

Die EconBiz-Autorenprofile zeigen die wichtigsten Forschungsgebiete von Autorinnen...