Diskussionspapier: Neue Indikatoren für Open Science und Open Innovation

Etablierte Indikatoren für Forschungs- und Innovationsprozesse erfassen Open Science und Open Innovation bislang unzureichend. Dadurch bleiben oft auch ihre Chancen und Risiken im Nebel. Ein neues Diskussionspapier unterbreitet daher Vorschläge für die Erweiterung vorhandener und die Entwicklung neuer Indikatoren. Wir haben uns mögliche Neuerungen für den Bereich Open Science angesehen.

von Birgit Fingerle

Um die Chancen und Risiken von Open Science und Open Innovation, auch für die Forschungs- und Technologiepolitik, besser identifizieren zu können, sollte die Erfassung, Analyse und Bewertung der Praktiken und Strukturen von Open Science und Open Innovation überdacht werden. Wie, das wird in dem Diskussionspapier “Open Science und Open Innovation – Neue Indikatoren für die Analyse des Wissenschafts- und Innovationssystems im digitalen Zeitalter” von Clemens Blümel, herausgegeben vom Stifterverband im September 2019, näher betrachtet.

Das Papier skizziert im ersten Schritt den Status quo bestehender Praktiken und Standards bei der Forschungs- und Innovationsindikatorik in Deutschland und analysiert vorhandene Fehlentwicklungen und Weiterentwicklungbedarfe. Anschließend werden daraus Probleme, Ziele und Konstruktionsprinzipien für eine neue Indikatorik abgeleitet und eine beispielhafte Auswahl darauf basierender möglicher neuer Indikatoren dargelegt. Darüber hinaus wird weiterer Forschungsbedarf zu Grundfragen der Indikatorik für offene Forschung und Innovation formuliert.

Neue Indikatoren für Open Science benötigt

Die Erhebung von Indikatoren zu Forschung und Innovation ist komplex und geschieht auf der Basis sehr unterschiedlicher Datenquellen. Während beispielsweise Angaben zur Innovationstätigkeit von Unternehmen häufig aus Eigenauskünften im Rahmen von wiederkehrenden Befragungen stammen, beruhen die Daten für Publikationen und Zitationen häufig auf Informationen aus bibliometrischen Datenbanken.

Inwiefern sich neuartige Innovationspraktiken mit den vorhandenen Leistungsindikatoren (etwa Publikationen, Patente) erfassen lassen, ist umstritten. So sinkt etwa die ohnehin sehr unterschiedlich ausgeprägte Neigung zum Erwerb von Schutzrechten in Sektoren mit schnelllebiger Innovations- und Technologiedynamik noch weiter, und damit fehlt es an Aussagekraft. Außerdem fokussieren die etablierten Indikatoren auf die Ergebnisse und Produkte wissenschaftlicher und technologischer Aktivität. Spezifische Ressourcen, die für wissenschaftliche und technische Aktivitäten Voraussetzung sind (zum Beispiel Datensätze, Software oder Code), werden jedoch kaum betrachtet, ebenso wenig wie neue Praktiken, wie die Zusammenarbeit mit Dritten und unüblichen Wissensgebern.

Auf Ebene der EU gab es bereits erste Versuche, neue Indikatoren für Forschung und Innovation zu entwickeln. Hierzu zählen unter anderem der Open-Science-Monitor (Link in englischer Sprache), Monitoring of Responsible Research and Innovation MORRI (Link in englischer Sprache) sowie Vorschläge für die Messung von neuen digitalen Forschungs- und Innovationspraktiken im Rahmen der Open Science Policy Platform.

Um Open Innovation- und Open Science Prozesse abzubilden, sollten sich Aktivitäten und Ergebnisse des Forschungsprozesses selbst zukünftig stärker in der Forschungs- und Innovationsindikatorik niederschlagen. Dazu gehört etwa das Teilen von Forschungsdaten oder Programmcodes. Bislang vorhandene Indikatoren sollten daher einerseits um den Aspekt der Öffnung ergänzt werden. Andererseits sollten wichtige neue Indikatoren zu ihrer Ergänzung vorgeschlagen und entwickelt werden. Einige der in dem Diskussionspapier exemplarisch genannten Beispiele für die Erweiterung von Open-Science-Indikatoren werden im Folgenden aufgeführt.

Zugänglichkeit des Wissenschaftssystems und Erfassung neuer Disseminationsformen

Für die Bereitstellung von Indikatoren, die Auskunft über den Grad der Öffnung des Zugangs zu wissenschaftlichen Ergebnissen geben, sind hauptsächlich Verbesserungen in der Erfassung und Abdeckung von Open-Access-Literatur erforderlich.

Die Messung des Zugänglichkeitsgrads wissenschaftlicher Literatur ist generell schwierig, da

- publizierte Literatur nachträglich im Open Access zugänglich gemacht werden kann,

- Referenzwerte für offen zugängliche Literatur schwierig zu finden sind und

- sich die Messverfahren für die verschiedenen Open-Access-Typen deutlich unterscheiden.

Um offene Formen wissenschaftlichen Outputs besser erfassen zu können, wird daher unter anderem vorgeschlagen, zusätzlich zu den in den etablierten wissenschaftlichen Datenbanken erfassten qualitätsgesicherten Zeitschriften Scopus (Link in englischer Sprache) oder Web of Science (Link in englischer Sprache), neue Datenbanken für die Messung von Open-Access-Zeitschriften heranzuziehen, wie das Directory of Open-Access Journals (DOAJ, Link in englischer Sprache).

Außerdem könnte eine Berücksichtigung von Preprints bei der Erhebung des Publikationsaufkommens erfolgen, die in manchen Fächern stark zur Öffnung und Diffusion des Wissens beitragen. Um die Anzahl der Preprints von deutschen Autorinnen und Autoren zu erfassen, müssten jedoch Probleme wie die Feststellung der Nationalität gelöst werden. Internationale Vergleichsdaten wären erforderlich, um nicht bloß den Umfang von Open Access zu messen, sondern einen internationalen Vergleich vornehmen zu können. Auch hierfür würde es umfangreicher Anstrengungen bedürfen, da ja nur ein Teil der Open Access-Beiträge in den etablierten Datenbanken erfasst wird und zudem die Erfassung von Land zu Land unterschiedlich ist. Hinzu kommt, dass die Datenqualität der Metadaten in den herkömmlichen Datenbanken für internationale Vergleiche bislang nicht zufriedenstellend ist. Da sich der Open-Access-Anteil zwischen den Disziplinen stark unterscheidet, sollten diese Indikatoren feld- oder disziplinspezifisch ausgewiesen werden.

Mit den beschriebenen Indikatoren wird alleine die Messung des Anteils an offen zugänglicher Literatur verbessert. Um auch Aufschluss über die Sichtbarkeit und Relevanz dieser Literatur zu bekommen, wäre auch eine eingehende Analyse der Rezeption dieser Publikationen wichtig. Zum Beispiel könnten hierfür die Zitationen von Open-Access-Artikeln und Preprints erhoben werden und so etwa der häufig genannte Zitationsvorteil von Open-Access-Literatur überprüft werden. Schwierig ist es bislang allerdings, Zitationen außerhalb klassischer Datenbanken adäquat zu erfassen. Hier wäre also weitere Arbeit nötig.

Ein weiteres Thema, das bei der Entwicklung neuer Indikatoren eine Rolle spielen sollte, ist die Erfassung neuer Formate für die Dissemination wissenschaftlicher Arbeit (etwa Videologs, Tedtalks, Science Slams, Blogs oder Wikis). Hierfür wird vor allem diskutiert, inwiefern offene oder alternative Metriken für deren Messung und Erfassung eingesetzt werden können.

Nachnutzung von Forschungsdaten und Programmcode messen

Die Erfassung der Nachnutzung von Forschungsdaten erscheint wichtig und ist komplex. Als eine wesentliche Voraussetzung dafür wird die Zuweisung von persistenten Identifikatoren gesehen. Quantitativ könnte die Bereitstellung von offenen Daten zunächst in Form der Anzahl an Open-Data-Plattformen und -Repositorien sowie ihrer Nutzung durch deutsche Wissenschaftlerinnen und Wissenschaftler erfasst werden. Die Einrichtung von Forschungsdatenzentren könnte als Indiz für vermehrte Nachnutzungsaktivitäten im Forschungs- und Innovationssystem dienen.

Für eine Erfassung dieser Repositorien könnten neue Angebote wie die Plattform Datacite (Link in englischer Sprache) herangezogen werden. Eine Schwierigkeit besteht bislang jedoch darin, dass Daten oft auf institutionellen oder disziplinären Repositorien abgelegt werden und somit schwierig auffindbar sind. Um nicht ausschließlich das Vorhandensein von Ressourcen abzubilden, sollten weitere Indikatoren entwickelt werden, die auch die Nutzung und die Interaktion von Forschenden mit Datensätzen erfassen. Hierzu ist allerdings anzumerken, dass eine Analyse der Nutzung von Forschungsdaten zum jetzigen Zeitpunkt schwierig ist, da das Verweisen auf Daten heterogen gehandhabt wird und keine Standards für Metadaten von Daten etabliert sind.

Aufgrund von Schwierigkeiten, die die Erfassung von Verweisen auf Datensätze in Texten bereitet, könnte eine Analyse der Nutzungsstatistiken von Datenrepositorien (wie Datacite oder Dryad (Link in englischer Sprache) als weitere Möglichkeit zur Erfassung von Open-Data-Effekten geprüft werden. Allerdings würde hierfür der sehr unspezifische und damit problematische Indikator des Downloads verwendet werden. Ebenso ließe sich das Sharing von Code, das Verfassen von Skripts und ähnlichem auf diese Art erfassen. Als Beispiel sei hier die Plattform Github (Link in englischer Sprache) genannt.

Die Reproduzierbarkeit wissenschaftlicher Ergebnisse stellt ein wesentliches Qualitätskriterium bezüglich der Dokumentation eines wissenschaftlichen Instruments dar. Die Anzahl der Replikationen von Studien könnte ein sinnvoller Indikator für die Qualität der Überprüfbarkeit offener Wissenschaftspraktiken sein. Einige Plattformen wie das Open Science Framework stellen bereits Informationen über die Durchführbarkeit und Reproduzierbarkeit von Studien bereit.

Citizen Science und Crowdfunding abbilden

Da die Beiträge von Laien zu Citizen-Science-Projekten im Allgemeinen über digitale Plattformen gesammelt und verarbeitet werden, kann die Anzahl der Projekte mit Citizen-Science-Anteilen sowie die Anzahl ihrer Teilnehmenden auf nationaler Ebene gut ermittelt werden. Dafür könnten etwa Daten des durch das BMBF geförderten Projekts “GEWISS” genutzt werden. Ein weiterer Indikator für die Inklusivität von Forschung und Technologie könnte die Anzahl der Unterstützerinnen und Unterstützer für und die Höhe der Fördersumme von Crowdfundingprojekten sein. Crowdfundingplattformen wie startnext oder betterplace, aber auch wissenschaftsspezifische Plattformen, wie etwa die von Wissenschaft im Dialog (WID) betriebene Plattform Science Starter sind mittlerweile recht etabliert. Demzufolge können ihre Daten sehr gut für das Monitoring der Inklusivität von Forschung und Innovation genutzt werden.

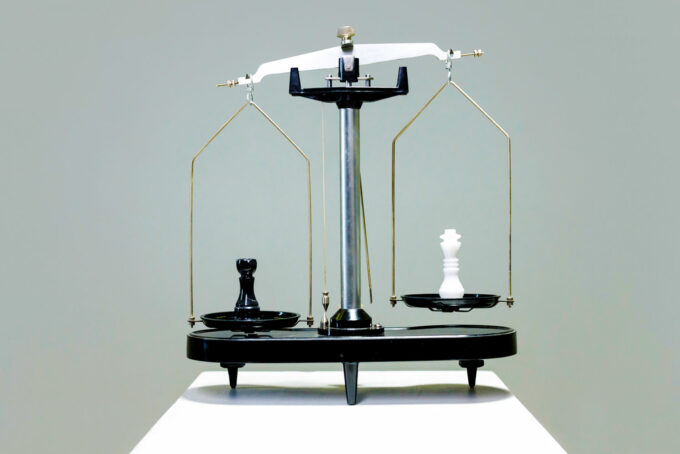

Chancen und Risiken neuer Indikatoren

Die Entwicklung neuer Metriken und Indikatoren für Open Science und Open Innovation wird von vielen Open-Science-Vertreterinnen und -Vertretern als Chance für die Schaffung neuer Anreize im Wissenschaftssystem gesehen. Zudem könnten mit der Einführung neuer Metriken auch andere wichtige Formen wissenschaftlicher Arbeit, etwa die Bereitstellung von Forschungsinfrastrukturen, die Softwareentwicklung oder die Wissenschaftskommunikation mehr Anerkennung erfahren. Darüber hinaus wird von der Einführung neuer oder alternativer Indikatoren eine Korrektur von Fehlanreizen durch Rückwirkungen bestehender Indikatoren erhofft. Zu ihnen zählen etwa die Fokussierung auf High-Impact-Journals, der Blick allein auf (überhaupt) zählbare Leistungen oder unbeabsichtigte Effekte von Output-Indikatoren auf das Verhalten von Individuen und Forschungsorganisationen.

Auf der anderen Seite stehen mögliche neue Risiken und Gefahren: So bergen beispielsweise die über Plattformen erhobenen Metriken ein hohes Manipulationsrisiko, oder aufgrund der Beschaffenheit von Interaktionskanälen kann es zu weitgehend inhaltsleerer Kommunikation kommen, und langfristige Fehlanreize können entstehen. Eine Folgenabschätzung neuer Indikatoren ist demnach bei ihrer Entwicklung notwendig, damit nichtintendierten Konsequenzen entgegengewirkt wird.

View Comments

Blockchain: Wie sie Forschung offener und transparenter machen könnte

Blockchains wird ein großer Nutzen für Wirtschaft und Gesellschaft zugeschrieben....